神奇动物之——自然界中的“伪装大师”

《西游记》作为四大名著之一,著作中的妖精和唐僧三徒都各怀“变化”绝技,为了实现长生不老,妖精们通过千变万化来蒙骗唐僧,例如白骨精通过三次变化,分别化为美丽的少女,寻女心切的老妇和老态龙钟的老头成功欺骗了肉眼凡胎的唐僧。妖精尚且如此内卷,在变化莫测的大自然动物们又是如何进行伪装的呢?

伪装策略本质上就是一种生存策略,在自然界中许多生物常为了更好的生存来伪装自己。比如动物中,北极狐的毛色会随着季节发生整体的变化,夏季的时候多呈现棕黄色,雪季的时候会变成通体的雪白色,还有我们比较熟悉的变色龙以及一些深海鱼类等。在植物中,有些高海拔地区物种的叶片会随着周边岩石的颜色发生变化,还有的比如生石花会模拟碎石的颜色和形态来起到隐藏自己的效果。

一、伪装的类型和机制

伪装就是生物通过形态、颜色、行为等特征上的调整,提高与环境或特定对象的相似性,从而提升生存与繁殖概率的一种适应性策略。这种伪装现象在动物、植物甚至是微生物界中都广泛存在。以功能为导向,分为保护性伪装和攻击性伪装,最终目的是 “不被吃”和“有的吃”。

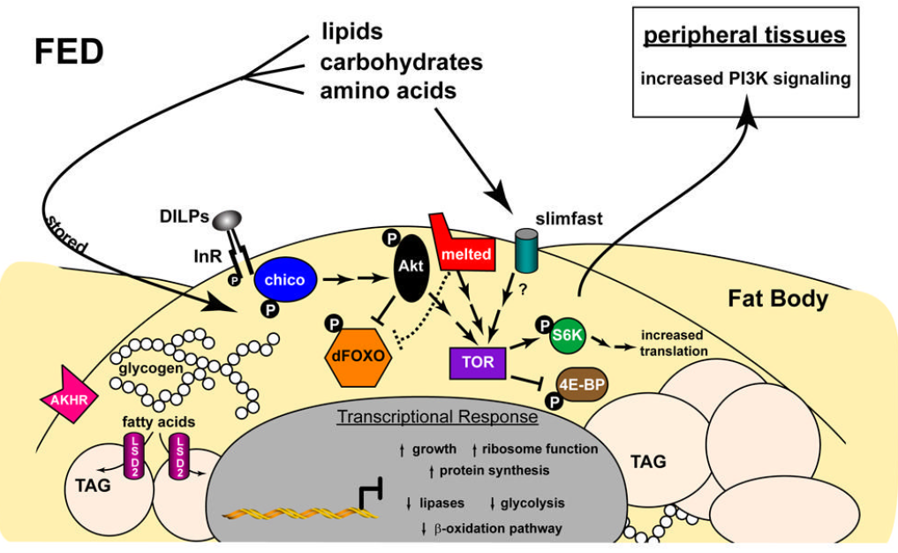

1、在保护性伪装里面,最基础的一个类型就是保护色。研究表明,60%以上的伪装属于此类,尤其在沙漠和森林生态系统中效果显著。通过体表颜色与栖息环境的颜色、色调的高度同步,让捕食者在对比度和亮度方面难以识别个体轮廓。经典一个例子是通用性伪装的“沙鼠”,它们利用沙地环境相似的棕色皮毛来躲避鸟类和其他捕食者的注意,这使得其中的大部分物种可以适应更广阔的栖息环境。另外经典的例子是一些光周期性毛发变色的哺乳动物如北极狐、雪兔雪貂等。其中雪兔中4号染色体上的Agouti(色素沉着基因)基因型和冬季毛色之间存在完美的一致性,Agouti光周期亚型相应浅色的毛色;雪貂中 MC1R 是一种众所周知的色素沉着基因,这种 G 蛋白偶联的黑素细胞跨膜受体在黑素生成中发挥关键作用 。α-黑素细胞刺激激素 (a-MSH) 是 MC1R 的激动剂,在黑素生成过程中触发深色真黑素(棕色至黑色色素)的产生,而信号蛋白 (ASIP) 的结合将黑素生成转变为浅色褐黑素(黄色至红色色素)的生成或抑制色素生成。MC1R 阅读框中的这两个连续核苷酸变化导致残基 101 处亮氨酸和赖氨酸之间的氨基酸变化,这种氨基酸变化需要两种核苷酸取代,并且发现该残基在深层进化规模上是保守的(基于 100 个物种,包括主要哺乳动物群体,亮氨酸是祖先状态)。在狗和狐狸的这个位置上只发现了一种具有相似生化特性的额外氨基酸——缬氨酸。

这些季节性变色的动物通过其毛发中的物理结构来散射光线从而呈现出我们眼中的白色外观,这主要是通过黑色素细胞的活动调节实现的,冬季黑色素细胞收缩,毛发变白。夏季黑色素细胞扩张,毛发变深。

在植物中,保护色伪装的一个案例是生活在高原流石滩中的半荷包紫堇,他们的叶片有绿色和伪装成岩石颜色两种类型。紫堇的主要天敌是一类叫食绢蝶的蝴蝶的幼虫。这种动物通过在紫堇植株附近产卵,孵化后幼虫会啃食叶片。通过全基因组关联研究(GWAS)发现了位于4号染色体上的一个显著变异,伪装植物中第二个内含子中的254个碱基对(bp)插入可能影响相关基因bHLH35,在伪装变体中,它在第二个内含子中包含从347到600 bp的254 bp插入作为转座子充当了bHLH35 基因的增强子,使得伪装叶片比绿叶有更高水平的花青素基因表达,从而表现为和背景类似的“灰色”伪装色。这样的“伪装”的好处是:带有伪装的紫堇叶片周围,食绢蝶的来访率要显著低于绿色叶片,并且食绢蝶要更偏向于在绿色叶片周围产卵,因此伪装叶片的被啃食率明显会低于绿色叶片,且结实率显著高于绿色叶片,在很大程度上维持了高山紫堇在自然环境下的生存。

2、第二种常见的保护性伪装是拟态。拟态指的是生物通过体形、体表结构的特化来模仿环境中的非生物或者无害生物,强化静态的隐藏效果。这类伪装方式在昆虫中特别多见,分为两类——①穆式拟态:被模仿的对象是一些有毒的不可食用的物种,一般会带有非常鲜艳的警戒色。那其他无毒的或者毒性较弱的物种通过模仿这种警戒色,共同强化 “危险信号”就可以降低被捕食者攻击的概率。南美洲的箭毒蛙属就属于这个类型,不同种的箭毒蛙携带的毒素强度不同,但基本都带有红、黄、蓝三色斑纹,他们之间共同构建 “鲜艳 = 有毒” 的警示信号。②贝氏拟态:被模仿者是有毒的,而模仿者一般是无毒的通过模仿有毒物种的外观和形态来迷惑捕食者。比如帝王斑蝶体内有食物来源的毒素积累,鸟类捕食帝王斑蝶以后会出现呕吐的现象。而另一种副王蛱蝶是无毒的,但是外形和体色和帝王斑蝶几乎一致,鸟类从而不敢捕食。

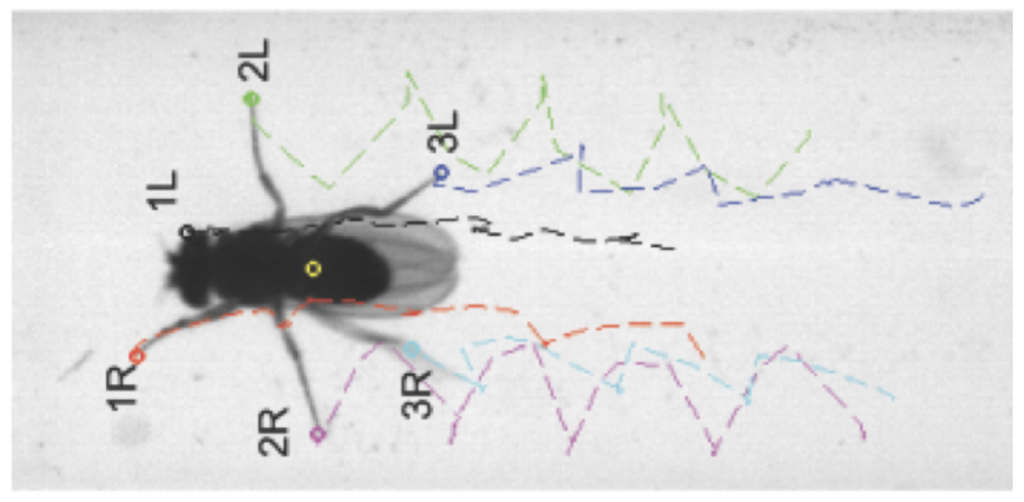

另外一些十分典型的例子比如竹节虫属,他们多以模拟树枝、落叶这些环境中的非生物来伪装自己。并且竹节虫在还是卵的状态的时候,就已经开始了拟态。他们的卵拥有多样的外形,外面是坚硬的卵壳,表面呈棕色或暗黄色,特别像植物的种子,因此也可以一定程度上避过天敌的取食;另一个有趣的例子是尺蠖,工业革命之后尺蠖出现了“黑色”变体,科学家认为这是自然选择的结果,尽管这样“进化”速度很快但是有证据支持的,cortex作为II型DNA转座子可以极快的响应这种变化。尺蠖的幼虫也极具“伪装天赋”,它们通过栖息地的不同可以伪装成不同栖息地的树叉(颜色和姿势)以此躲避捕食者的攻击,这种伪装并不完全相应于视觉线索(遮蔽眼睛的尺蠖幼虫也可根据树叉颜色的变化调整体色)。还有其他“拟态保护”的例子如:食蚜蝇通过模仿蜜蜂来迷惑捕食者,一种蜘蛛可以通过步态模仿蚂蚁来隐藏真实的自己等等(穆氏拟态)。

3、第三种保护性伪装是破坏性着色,它是通过体表的斑块、条纹等花纹,来打破生物自身的身体轮廓,使捕食者难以识别其整体形态,尤其是在动态或复杂环境中,一般会具有局部对比度增强或者边缘增强的效果。以铜头蛇为例,它身上的斑纹就是典型的边缘增强型破坏性着色,通过深色边缘颜色更深,浅色边缘颜色更浅来强化这个虚拟的边缘形成一个假轮廓,显著阻碍目标识别。

4、攻击性伪装的核心目的是帮助捕食者隐藏自身、迷惑猎物来提高捕食的成功率,或者也有吸引配偶的繁殖型攻击性伪装,本质就是用伪装主动获取利益。最多的就是伏击伪装,捕食者通过体色、形态与环境的融合潜伏在猎物活动区域,待猎物靠近时突然出击,降低猎物的逃逸概率。像动物里豹子、角蛙,竹叶青这些都属于是伏击伪装;在植物中,猪笼草是少数的存在捕食行为的植物之一,颜色、斑纹和周围环境相似,还会在笼口的边缘分泌类似花蜜的液体,并且边缘是倾斜的,昆虫很容易被吸引然后滑进笼中。再如兰花螳螂,外形酷似一朵盛开的兰花,能分泌一些挥发性物质模拟兰花的香气,兰花螳螂的体色随着发育过程是会改变的,幼年时期是黑红色的(幼年通过模拟有毒昆虫的警戒色来躲避天敌),成年后变为粉色或者白色(通过拟态成兰花,一方面迷惑访花的昆虫,另一方面隐藏自身,避开鸟类等天敌的捕食)。

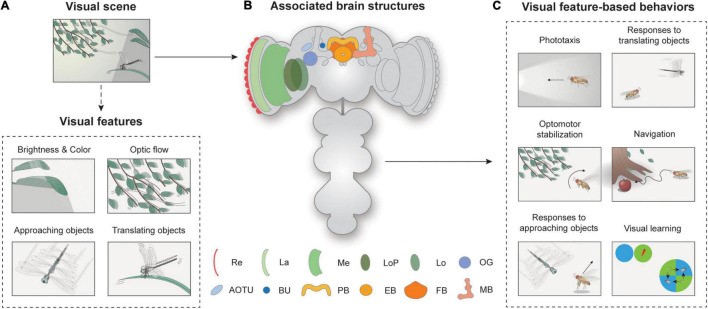

比较高阶的攻击性伪装叫做动态伪装,是一种 “实时伪装”。如斑马(群体高速奔跑下通过黑白条纹中色素分子不同方向的矢量运动模糊捕食者对其外轮廓的捕捉),另一个重要的例子是变色龙,通过主动调节 S-虹彩细胞中鸟嘌呤19纳米晶体晶格的光子响应来快速改变颜色。当变色龙放松时,纳米晶体间距较近,会反射短波长的光(如蓝光);当它兴奋时,皮肤收缩使纳米晶体间距变大,转而反射长波长的光(如红、橙、黄光);最底层是黑色素细胞,其延伸出的触角能直达皮肤表层,可通过调节黑色素的分布,加深或减淡整体肤色。在头足类动物和部分鱼类中把动态伪装作为主要的生存策略。如斧鱼,当被环境光和/或捕食者的探照灯照射时,鱼皮肤中的复合折射结构会增加所有视角的伪装,鳞片的反射率增加了到探照灯捕食者的瞄准距离以及环境光中的检测距离。与此同时,任何射入侧翼的光线也会通过腹侧斜鱼线向下定向,为任何向上看的掠食者提供隐藏力量,以对抗向下流的照明;安康鱼通过拟饵来吸引猎物或配偶。海洋中的软体三雄作为目前研究中变色最快的动物为“伪装”提供了很好的研究模型,如其中之一的乌贼,三种主要体型类型,即均匀型、斑驳型和破坏型,通过相应环境的变化来实现快速变色。它们的快速变色得益于:色素细胞和乳凸,由从大脑投射的运动神经元控制。颜色图案是由色素细胞产生的:充满色素的可膨胀囊,在大脑投射的运动神经元的控制下,被肌肉包围。当神经元兴奋时,色素囊周围的放射状肌肉收缩,色素细胞扩张,在皮肤上形成一个可见的彩色斑点。在没有神经元激活的情况下,色素细胞收缩成一个难以察觉的点,露出动物下面的白色皮肤层。通过扩大不同颜色的色素细胞的组合,动物可以创造出条纹和斑点的动态图案,神经元的控制使色素细胞的扩张在约100毫秒内发生,创造了地球上已知最快的动物颜色变化。具体来说,这种调控是通过视网膜中的神经元投射到视叶,视叶神经元依次投射到外侧基底叶,最后外侧基底叶神经元投射到色素细胞叶。

二、伪装的意义和应用

伪装作为自然界中的保护手段,是自然选择的直接产物。它的意义包括提升生存率和环境适应性;调节物种间的相互作用,维持生物的多样性。与此同时动物的伪装也使得人类更加的受益,“伪装”广泛的应用于军事和材料科学领域。如模仿章鱼皮肤,开发出的一款能在红外波段下实时“隐身”的人造薄膜材料,使表面的总反射率完全变化,逃过红外相机的监测;生物的伪装还有许多跨领域的创新成果,比如通过拟态诱虫板诱捕害虫,减少农药使用;在网络安全方面,类比生物的拟态防御通过动态改变系统端口特征来主动迷惑黑客攻击,构建一个拟态防火墙来提升系统的安全性;在生活中可以利用“伪装”的反向思维,旅游穿搭要和环境背景有反差,这样才比较“出片”!

本次journal club的 slides 见附件pdf:

by 王蓉、马铭泽、陆彤